知情人士透露,聊天機器人ChatGPT的開發商OpenAI近期開始租用Google的人工智慧(AI)晶片,以支援ChatGPT及其他產品的運算需求。這是OpenAI首次實質採用非輝達(Nvidia)晶片,也反映出該公司正透過多元供應策略,逐步擺脫對主要金主微軟(Microsoft)雲端資源的高度依賴。

路透報導,OpenAI是輝達圖形處理器(GPU)的最大買家之一,這些AI晶片被用於訓練模型與推論運算,也就是AI模型根據新資訊進行預測或決策的過程。OpenAI希望降低推論階段所產生的運算成本。

根據路透本月稍早的獨家報導,OpenAI計劃導入Google Cloud服務,以應對日益增加的運算需求。這也標誌著兩家AI領域主要競爭者之間出人意料的合作。

對Google而言,此交易正值其擴大內部自行開發的張量處理單元(TPU)對外供應之際。TPU原本僅供內部使用,如今則吸引包括科技巨頭蘋果公司在內的客戶,以及由OpenAI前高層創辦的Anthropic與Safe Superintelligence等新創公司,這兩家企業亦為ChatGPT的競爭對手。

金融新聞網站Investing.com報導,過去,OpenAI主要透過與微軟和甲骨文(Oracle)的合作來取得Nvidia晶片,用於訓練與部署其AI模型。儘管Google已開始提供部分TPU算力給OpenAI,然而,《The Information》引述一位Google Cloud員工稱,作為AI競爭對手的Google,並未將其最強大的TPU出租給OpenAI。

這項限制顯示,Google仍將其最先進的TPU保留用於內部使用,例如支援Gemini計劃下自家大型語言模型的開發。不過對OpenAI而言,即便僅能使用早期版本的TPU,也象徵著其基礎設施多元化邁出關鍵一步,特別是在業界對運算資源需求持續上升之下。

目前尚不清楚OpenAI是否會將Google晶片用於模型訓練,或僅限於推論階段使用。隨著競爭加劇與資源壓力上升,採用混合型基礎架構可能為OpenAI帶來更多擴展上的彈性。

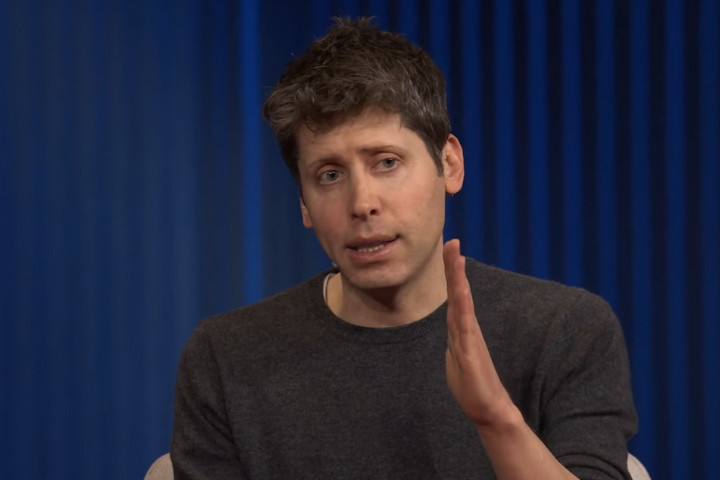

此次OpenAI租用Google TPU的舉動,代表該公司首次在實質上使用非輝達的晶片,也顯示出這家由奧特曼(Sam Altman)領導的企業,正逐步降低對投資方微軟資料中心的依賴。根據《The Information》的報導,TPU可能成為相較於Nvidia GPU更具成本效益的替代選項。

Google對此不予置評,而OpenAI在路透聯繫時亦未立即回應。

這項安排凸顯AI硬體市場的演變動態。像Google這樣的公司正利用多年來在軟體與客製化晶片方面的投資優勢,擴大影響力。對OpenAI而言,將Google納入其晶片供應商體系,不僅拓展技術堆疊的生態圈,也因應了業界對運算資源可用性與成本日益升高的擔憂。